近期,国际学术期刊National Science Review在线发表了中国科学院分子细胞科学卓越创新中心(生物化学与细胞生物学研究所)陈洛南研究组与中山大学陈川副研究员、苏州大学马欢飞教授、东京大学Kazuyuki Aihara教授等合作研究成果“Predicting future dynamics from short-term time series by anticipated learning machine”。该成果基于延迟嵌入理论(delay embedding theory),提出面向小样本时序预测的预见性学习机器(ALM: Anticipated Learning Machine)方法,从而为该类问题提供了全新的解决方案。同时ALM可看作是由高维小样本数据构建被预测变量的大样本数据方法。

时序预测在许多领域都有着重要应用,如基因组表达预测、海平面温度变化预测、风力预测、空气污染预测、疾病预测、股票预测等。传统的时序预测方法多是基于统计学或者机器学习,由于统计学或机器学习方法行之有效的条件是观测到足够长期时序数据或大样本数据,而小样本往往不能获得完整的系统动力学行为或统计规律,因此短期时序或小样本数据的预测一直是时序预测中的难点。另一方面,由于实际系统多为时变系统,对于未来预测来说,只有最近观测的数据更有效,所以即使是观测了大样本,实际有效数据都为小样本。对于这个问题,我们在神经网络框架下,结合动力学的随机分布嵌入理论 (RDE: Randomly Distributed Embedding),建立了由高维系统中不同变量间的交互作用信息构建目标变量或预测变量的动态信息的ALM方法,弥补了小样本的信息不足。特别是,构建了由高维短期时序数据与预测变量长期时序数据两者间映射关系,通过将高维短期时序数据转化为低维长期时序数据从而实现了小样本数据的时序预测。

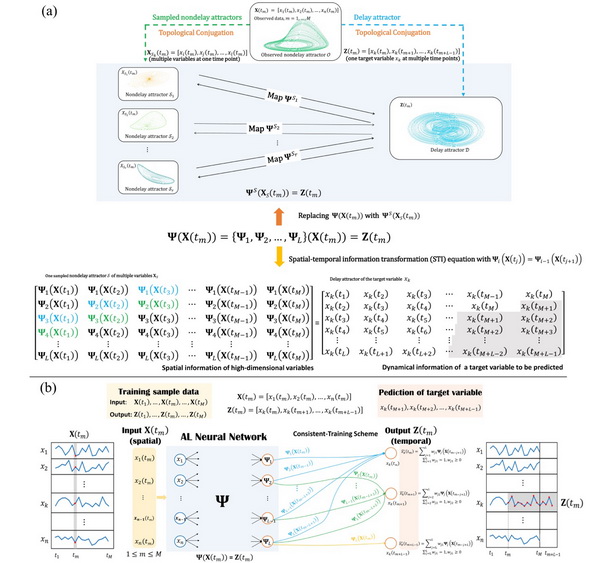

研究者采用全新的空间-时间信息转换(STI: Spatial-Temporal Information transformation)方法,建立了基于小样本的预见性学习机器(ALM)神经网络(图1),利用神经网络全面和鲁棒地学习这空间-时间的非线性映射(STI)。有别于传统学习的线性近似映射,神经网络出色的非线性函数学习能力使得神经网络可以更好的模拟STI映射。另外,ALM神经网络的Dropout也可以很好的模拟随机采样的过程,所构建的ALM神经网络可以综合多个子采样系统中的动力学信息,得到最终的多步预测。实验表明,该ALM方法在洛伦兹系统、基因表达预测、风速预测、股票预测、车流量预测、台风路径预测等多个实际数据集上都能做出准确的多步预测。

该工作对于小样本的时间序列数据分析提供了全新的的预见性学习机器方法,不仅可用于时间序列的多步预测,也可应用于人工智能及脑科学中的小样本数据构建和全新学习建立等。

该研究得到了该研究得到了科技部、中国科学院和国家自然科学基金的经费支持。

文章链接

Figure 1 (图1): Anticipated Learning Machine (ALM:预见性学习机器-神经网络). (a) The general principle of Anticipated Learning Machine. The observed attractor, a delay attractor and sampled nondelay attractors are all topologically conjugate with each other. Each sampled nondelay attractor preserves the dynamical information of the system in different ways. By integrating the information contained in these sampled nondelay attractors, we could find an accurate one-to-one map even under noise deterioration. (b) Anticipated Learning Machine. For each future value, those maps are co-trained into a unified map

. When the maps are trained, the weighted sum is used as the prediction. The predicted value is then used as the label when training other maps to predict the next time point. Clearly, ALM transforms spatial input X(tm) to temporal output Z(tm) at each point tm.